Appleの「iPhone」シリーズにとって2024年は厳しい年になるだろう。ウォール街はこのように予測している。ハード面で興味を引くような新機能がない、というのがその理由だ。では、人工知能(AI)ソフトウェアは「iPhone 16」の魅力を高められるだろうか。

提供:Jason Hiner/ZDNET

Apple株に対して強気な見方をする人の中には、そうなると考える人もいる。Morgan Stanleyのアナリスト、Erik Woodring氏が1月に述べたところによると、2024年は「Appleの『エッジAI』が実を結ぶ年」になり、エッジAIによって新しいiPhoneシリーズはさらなる高みへと引き上げられる可能性があるという。

FactSet Research Systemsがまとめた推計によると、最新機種の「iPhone 15」を中心とするAppleの2024年のiPhone販売台数は、約2%減少して2億2900万台になる見通しだという。iPhone 15シリーズにはこれまでと似たハードウェア機能しか搭載されておらず、ユーザーの期待に応えられていないからだ。

しかし、強化されたAI機能が「iPhone 16」に搭載されれば、2025年は前年比約4%増の2億3700万台という現在のウォール街の予測が、15%増になる可能性もある、とアナリストのWoodring氏は述べている。

「われわれの予想通りに事が進み、LLM対応の新しいソフトウェア機能がアップグレードサイクルを促すことになれば、2025会計年度のiPhoneの出荷台数は予測に対して最大15%まで上振れすることもありえる」(Woodring氏)。なおLLMとは、OpenAIの「GPT-4」などの「大規模言語モデル」(Large Language Models)を指す。

2024年夏に開催されるAppleの「Worldwide Developer Conference」(WWDC)で、世界の人々は詳細を知ることになるだろう、と同氏は推測する。「目玉となるのは、LLMを搭載した『Siri 2.0』と、iPhoneのアップグレードサイクルを促進する可能性を秘めた、より広範な生成AIに対応するOSだ」

「LLM搭載」がなぜそれほど重要なのだろうか。OpenAIのGPT-4のようなLLMを使用するには、スマートフォンがネットワークを介して、プロンプトを送信し、応答を取得する必要がある。イーサネット接続を備えたデスクトップコンピューターでも、ラウンドトリップが発生し、応答が返ってくるまで少し待たなければならない。セルラーネットワークを使用しているモバイルデバイスでは、クラウド接続を利用すると、「Siri」がフリーズしたようなぎこちない動作になる場合もある。

代替策として必要なのは、クラウドに依存することをやめて、LLMの処理をもっとローカル、つまりデバイス上で実行することだ。iPhoneには、AIの実行に特化したエンジンである「Neural Engine」がすでに搭載されている。ただし、Neural Engineによって実行されるAIタスク(LLMよりもはるかに負荷の低いタスク)は、使用する回路が慎重に選定されている顔認識機能などの非常に入念に定義された機能であることが多い。

一般的なLLMをローカルで実行するのは、それよりもはるかに高負荷のタスクになるはずだ。

Woodring氏が2024年にAIが搭載される可能性について期待している最大の背景は、Appleの研究者、Keivan Alizadeh氏とその同僚らによって1月に発表された「LLM in a flash: Efficient large language model inference with limited memory」(フラッシュメモリー内のLLM:限られたメモリーを使用した効率的なLLM推論)という論文だ。この論文は、プレプリントの論文を発表するサーバー「arXiv」に投稿された。

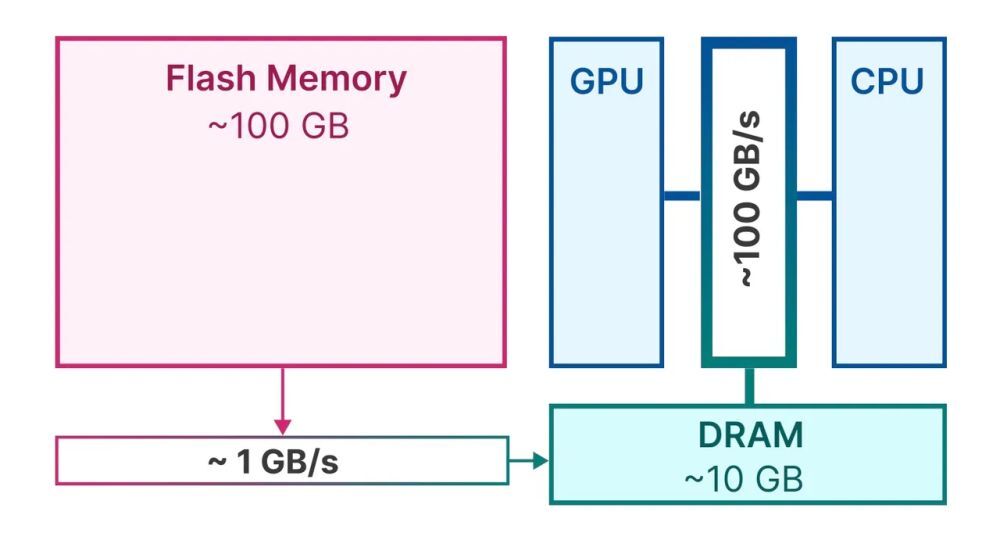

この論文の要点は、LLMはメモリーを大量に消費するが、Appleは常駐フラッシュメモリー(iPhoneのファイルを保持する領域)の大容量ストレージを使用する賢い方法を見つけた、というものだ。特別なソフトウェアを使用すると、LLMをメインメモリーであるDRAMに移動したりDRAMから移動させたりすることが簡単になり、DRAMの容量が通常よりもはるかに増えたかのように活用できる。

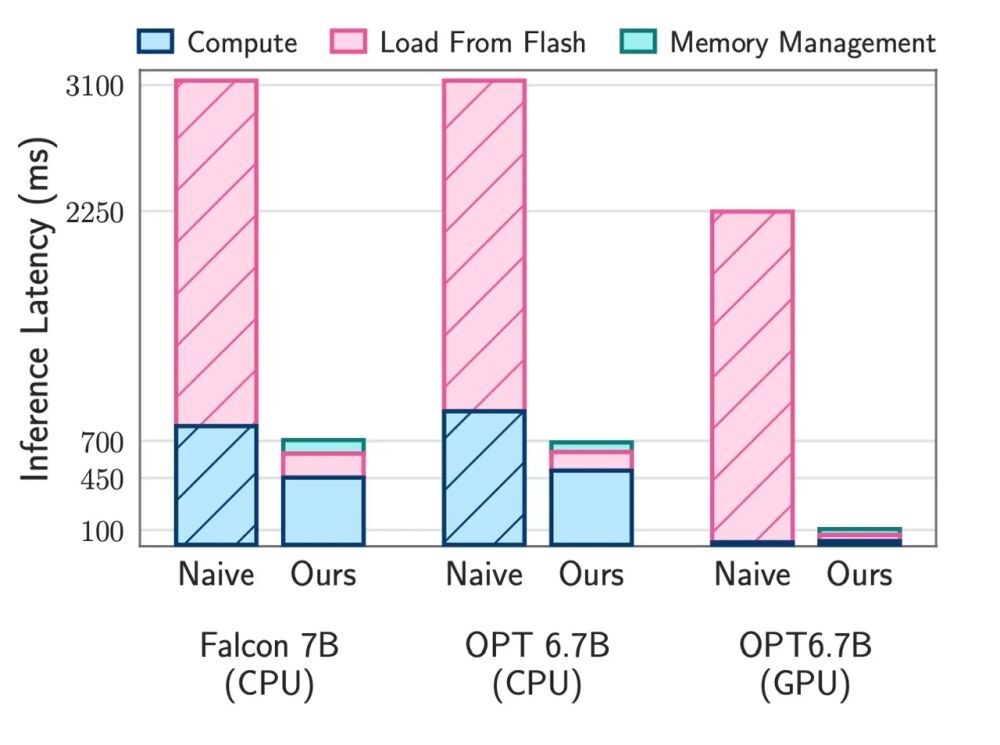

Alizadeh氏と同僚らによると、メモリーに関して同氏らが採用する手法によって、「利用可能なDRAMの最大2倍の容量でモデルを実行することが可能」になり、デバイス上での予測も25倍高速化するという。

同氏らが取り組んでいるのは、LLMが大きくなる一方であるにもかかわらず、ほとんどのスマートフォンには十分な容量のDRAMが搭載されていないという問題だ。論文は、「パラメーターが70億個のモデルでは、パラメーターを半精度浮動小数点形式でロードするだけでも、14GB以上のメモリーが必要になる。これは、ほとんどのエッジデバイスの能力を超えている」と指摘し、ニューラルの「重み」、つまり「パラメーター」に言及している。パラメーターとは、メモリーに保存され、訓練されたニューラルネットワークを具体化する値のことだ。

Appleは搭載しているDRAMの容量は公表していないが、「Mac」関連の情報を掲載するサイトEverymacは、「iPhone 15 Pro Max」が8GBのDRAMを搭載していることを示唆するサードパーティーのデータを引用している。なお、サムスンによると、先頃発表された「Galaxy S24 Ultra」には、12GBのDRAMが搭載されているという。

もちろん、スマートフォンのNAND型フラッシュストレージは、それよりもはるかに大容量のメモリーを備えている。iPhone Pro MaxもGalaxy S24 Ultraも最大1TBのメモリーを搭載している。それよりも大きい問題は、データの出し入れだ。NANDフラッシュはDRAMメモリーよりも遅いため、毎回NANDフラッシュメモリーからデータを取り出そうとすると、DRAMだけを使用する場合よりも低速になる。

提供:Apple

さらに、フラッシュメモリーからDRAMメモリーへのデータの移動には転送時間がかかり、ユーザーが実行しようとしていることが完了するまでに遅延(レイテンシーと呼ばれる)が生じる。これは、クラウドを利用するときと同じように、ユーザーがLLMにプロンプトを入力してから応答が得られるまでに数秒の待ち時間が発生する可能性があることを意味する。なお、DRAMからスマートフォンのCPUにデータを移動する際にも遅延が生じる、と論文は指摘している。

同氏らの解決策は、LLMを含むニューラルネットワークの基本的な側面、つまりスパース性を利用することだ。スパース性とは、ニューラルネットワークを構成するニューラルの重みの多くが実際には空っぽであることを意味する。数値は0だ。つまり、それらは無視できるため、メモリーからフェッチする重みは総量のごく一部だけで済む。

「LLMはスパース性が高い(中略)われわれは、このスパース性を利用して、0以外の入力を持つパラメーター、または0以外の出力を持つと予測されるパラメーターだけをフラッシュメモリーから選択的にロードする」(同論文)

さらに、この論文では、0以外の重みのどれをフラッシュメモリーから呼び出すかについて、ユーザーが次にトリガーする可能性のある予測タスクに基づいて、最も必要とされるであろう重みをプリフェッチするなど、巧みな手法も数多く考案されている。

この論文では、Metaの「Open Pretrained Transformer」(OPT)と、アブダビを拠点とするTechnology Innovation Instituteの「Falcon」という2つのオープンソースLLMを実行したときに、速度が劇的に向上することが実証されている。

提供:Apple

Woodring氏らは、iPhone 16がAI用のスーパーコンピューターになることを期待しているが、それには1つだけ問題がある。Alizadeh氏らの論文で紹介されている検証作業は、Mac上で実行されているということだ。具体的に言うと、論文で紹介されている手法は、いずれもAppleの「M1 Max」プロセッサーで開発されている。このプロセッサーは、「MacBook Pro」と「Mac Studio」デスクトップにしか搭載されていない。このチップは、iPhone 15に搭載されている「A17 Pro」よりもかなり大型で強力だ。

さらに、論文にも書かれているが、著者らが実施したテストでは、スマートフォンユーザーが最も気にすることの1つ、バッテリー持続時間が考慮されていない。「今後の調査の重要な側面は、特にデバイス上での展開に関して、われわれが提案する方法に本質的に伴う電力消費と発熱による制約を分析することだ」(同論文)

とはいえ、Appleの「M」シリーズのシリコンはモバイルデバイスで広く採用されるようになっている。初代の「M1」チップや「M2」チップは、「iPad Pro」や「iPad Air」といったタブレットの複数のモデルに搭載された。これは、Appleのチップとソフトウェアの取り組みの両方に、Alizadeh氏とチームが探求しているような連続性があることを意味している。

iPhone 16シリーズに搭載されるとうわさされている「A18」プロセッサーは、スマートなスパース性の実行とバッテリー消費の節約の適切なバランスを見つけられる可能性がある。最初のステップとして、論文で説明されているようなアプローチを、極めて小規模なLLMで試してみることも可能かもしれない。Alizadeh氏が論文でテストした2つのモデルには、約70億個のパラメーターがある。これは、LLMとしてはかなり小規模である。あるいは、電力とメモリー、CPUの使用量を節約するために、より小規模な、パラメーターが10億個以下のモデルを採用してもいいだろう。

WWDCやiPhoneの発表イベントで披露される内容が何であれ、Alizadeh氏とチームによる研究の骨子から推測できるのは、遅かれ早かれAIはクラウドからユーザーのポケットにやってくるということだ。

この記事は海外Red Ventures発の記事を朝日インタラクティブが日本向けに編集したものです。

from "鍵" - Google ニュース https://ift.tt/NzkTf6l

via IFTTT

Bagikan Berita Ini

0 Response to "「iPhone 16」成功の鍵はエッジAI--メモリーの制約を乗り越えられるか - CNET Japan"

Post a Comment